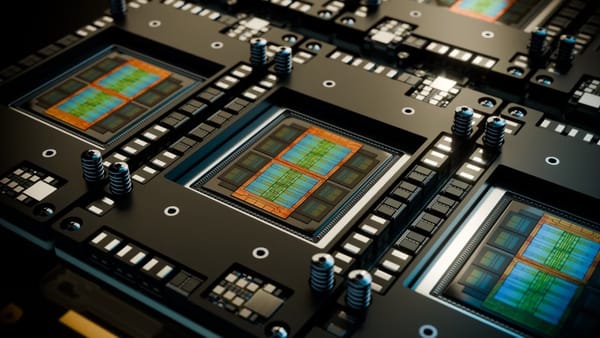

AMD acaba de lanzar su nueva serie de GPUs Instinct MI350, diseñadas específicamente para acelerar aplicaciones de inteligencia artificial, entrenamientos masivos y cargas de trabajo de computación de alto rendimiento. Estas GPUs prometen cambiar las reglas del juego en el mercado empresarial.

La compañía reveló oficialmente la serie MI350 en junio de 2025, posicionándola como la respuesta directa a las demandas actuales del mercado AI. Con arquitectura CDNA de 4ta generación, estas GPUs buscan ofrecer un rendimiento superior manteniendo la eficiencia energética que requieren los centros de datos modernos.

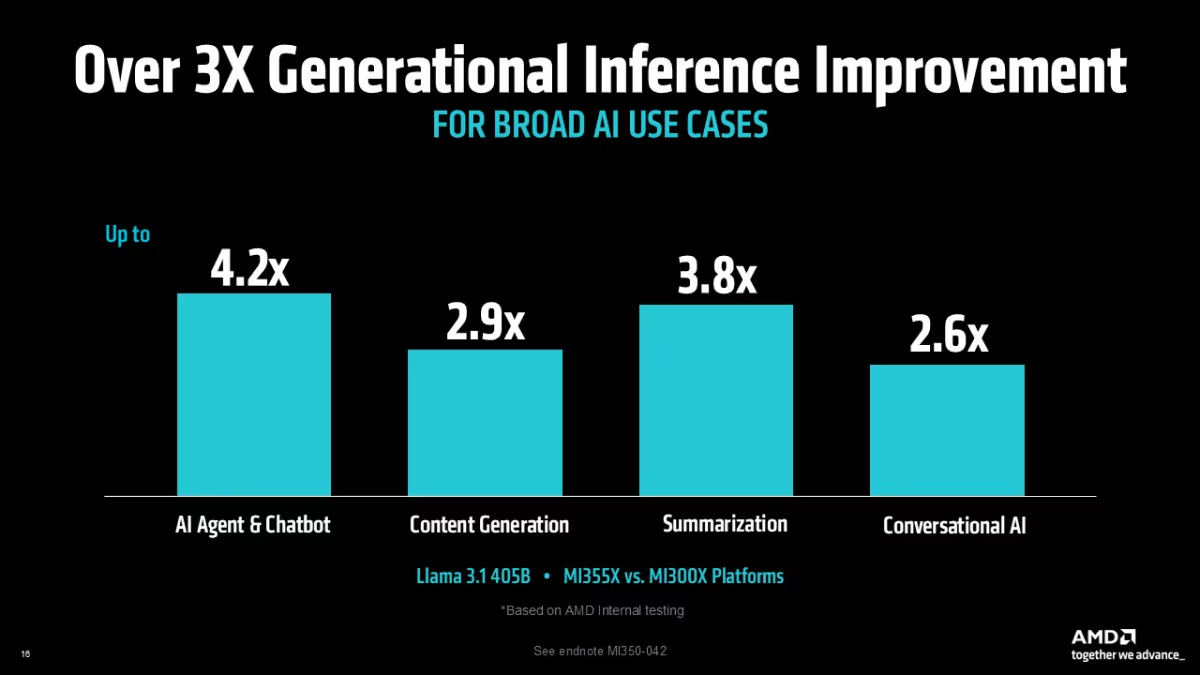

Rendimiento que marca la diferencia en aplicaciones AI

Las pruebas realizadas con el modelo Llama 3.1 405B demuestran mejoras significativas en múltiples áreas de aplicación. La plataforma MI355X logra hasta 4.2X mejor rendimiento en agentes AI y chatbots comparado con la generación anterior MI300X. En tareas de generación de contenido, el aumento alcanza 2.9X, mientras que en resúmenes automatizados llega a 3.8X.

"La serie MI355X ofrece hasta 4X mejor rendimiento teórico que la generación MI300X, basado en mejoras arquitecturales y formatos de precisión soportados".

Estos números no son solo teóricos. En aplicaciones conversacionales de AI, la mejora de 2.6X se traduce en respuestas más rápidas y mejor experiencia para usuarios finales en implementaciones empresariales.

Capacidades técnicas para entornos de producción

El diseño de la serie MI350 incluye hasta 288GB de memoria HBM3E, eliminando los cuellos de botella tradicionales en modelos de gran escala. Esta configuración permite ejecutar aplicaciones que antes requerían múltiples GPUs en una sola unidad, simplificando la arquitectura del sistema.

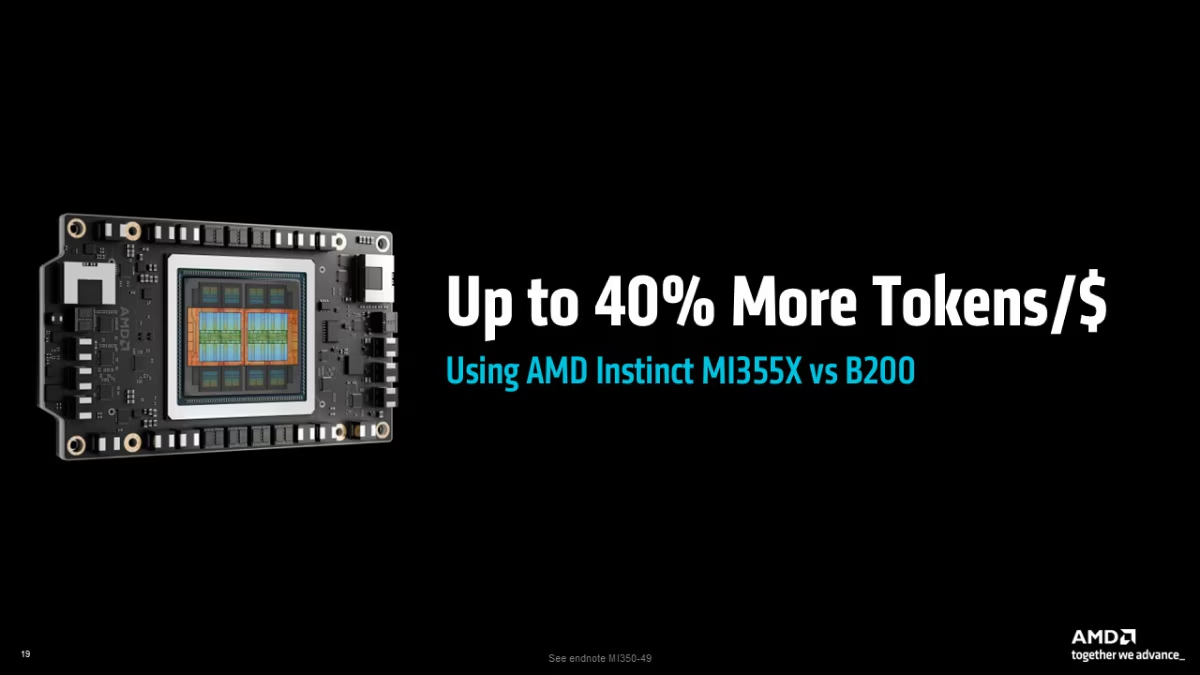

La eficiencia económica también mejora sustancialmente. Los tests muestran hasta 40% más tokens por dólar en comparación con las opciones B200, lo que representa ahorros significativos en operaciones a gran escala.

Para entrenamiento de modelos, la plataforma ofrece mejoras de 1.13X en tiempo de entrenamiento comparado con soluciones Nvidia B200. En modelos Llama 2-70B, el tiempo de fine-tuning se reduce 1.12X, optimizando los ciclos de desarrollo.

Arquitectura pensada para escalabilidad empresarial

La serie MI350 está disponible en configuraciones air-cooled y direct liquid-cooled, adaptándose a diferentes infraestructuras de centros de datos. Las plataformas MI350X y MI355X ofrecen flexibilidad para diversos casos de uso, desde inferencia hasta entrenamiento intensivo.

El software AMD ROCm™ continúa evolucionando para maximizar el aprovechamiento del hardware. La versión 7 incluye optimizaciones específicas para Flash Attention, Transformer Engine y operaciones GEMM, elementos críticos en aplicaciones AI modernas.

Las mejoras en rendimiento de inferencia alcanzan 3.5X en modelos como Llama 3.1 70B, mientras que en entrenamientos el aumento promedio es de 3X comparado con generaciones anteriores. Esta consistencia en mejoras permite planificar migraciones con beneficios claros y medibles.