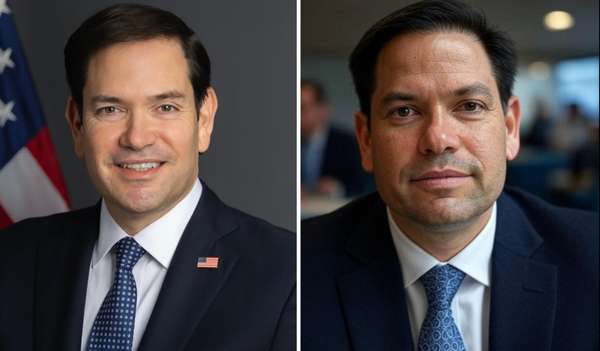

Hace unos días, Marco Rubio, Secretario de Estados Unidos, sufrió la suplantación de su voz y las alarmas se encendieron. La noticia "Marco Rubio fue clonado por IA" dio la vuelta al mundo porque sí, el personero de gobierno de Donal Trump, blindado y protegido, era víctima de hackers que utilizaron como herramienta la Inteligencia Artificial.

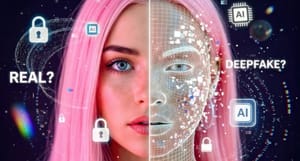

El riesgo creciente para todas las personas y Estados fue analizado por Pete Nicoletti, CISO de Campo Global en Check Point Software, advirtiendo que las herramientas de IA que pueden clonar una voz, una foto o crear un video a imagen de cualquier persona, ahora son simples, accesibles y peligrosamente convincentes, lo que impulsa un aumento de lo que se llama eventos 'Post-Reales'.

Así lo adelantó el Reporte de Seguridad de IA de Check Point Software, detectando el robo de 24 millones de dólares durante una llamada de Zoom, donde todos los participantes, excepto el director financiero, fueron generados por IA.

“Ahora, se está ´citando´ a políticos con declaraciones que nunca hicieron, e incluso las empresas están contratando, sin saberlo, a solicitantes de empleo generados por IA que luego acceden a datos confidenciales”.

Este último deepfake dirigido al senador Marco Rubio es solo otro paso alarmante en una crisis creciente. Otro detalle notable es que el hacker tenía acceso a números de teléfono que funcionaban, lo que sugiere un mayor nivel de preparación y una posible vulneración de datos.

“Ya no podemos confiar en señales obsoletas como seis dedos o mala iluminación para detectar una falsificación. ¡La IA ha evolucionado! Las organizaciones necesitan implementar medidas proactivas. Contramedidas: usar palabras clave previamente acordadas y compartidas fuera de banda antes de las reuniones, y durante las videollamadas, pedir a los participantes que muestren la parte posterior de la cabeza, una zona que la IA actual tiene dificultades para replica”.

Herramientas como www.facecheck.id pueden ayudar a detectar el uso no autorizado de una imagen, pero, en última instancia, la defensa clave es educar a las personas para que reconozcan y respondan a estas amenazas.

Micki Boland, Tecnóloga gGobal de Check Point Software, añade:

“Este incidente marca un nuevo capítulo en la ingeniería social basada en deepfakes. La suplantación de un funcionario de alto nivel como el secretario de Estado Marco Rubio evoca ataques similares, como el deepfake del ministro de Asuntos Exteriores de Ucrania dirigido al senador estadounidense Ben Cardin en 2024. Si bien no podemos confirmar quién está detrás de este último suceso, es probable que la intención implique manipular narrativas geopolíticas, acceder a información restringida y socavar la confianza diplomática”.

Las herramientas de IA generativa actuales pueden fabricar audio, vídeo e incluso textos altamente engañosos, pero según Pete Nicoletti, lo que hace sofisticado a este ataque es el uso calculado de la ingeniería social:

"identificar objetivos vulnerables, entrenar modelos de IA con datos personalizados y orquestar campañas de desinformación creíbles en redes sociales. No se trata de ataques aleatorios. Se trata de campañas de información maliciosa: uso estratégico y malicioso de narrativas manipuladas para engañar y desestabilizar".

Las organizaciones equipadas con una solución robusta de Gestión de Riesgos Externos (ERM) podrían ser capaces de detectar señales tempranas de tales ataques, especialmente si los actores de amenazas utilizan cuentas falsas o coordinadas para amplificar narrativas maliciosas y difundir información maliciosa, donde el experto señala:

“He estudiado las aplicaciones reales de estas tecnologías a través del curso ‘Inteligencia Artificial y Aprendizaje Automático Sin Código: Desarrollo de Soluciones de Ciencia de Datos’ del MIT, y es evidente que los actores de amenazas se están volviendo más creativos y capaces. Las organizaciones deben evolucionar sus estrategias de detección y prepararse para un mundo donde la verdad se puede fabricar en segundos”.