AMD detalla en OCP 2025 cómo la infraestructura de IA abierta y basada en estándares puede escalar desde el rack hacia clústeres completos, evitando dependencias de un solo proveedor y habilitando innovación sostenida. La propuesta se apoya en interconexiones abiertas, software abierto y una arquitectura de rack como nueva unidad de cómputo.

¿Cómo propone AMD escalar IA con interconexiones abiertas?

El enfoque parte de que el rack es la unidad de cómputo para IA a gran escala y que la interconexión define rendimiento, latencia y eficiencia, por lo que debe ser abierta y componible.

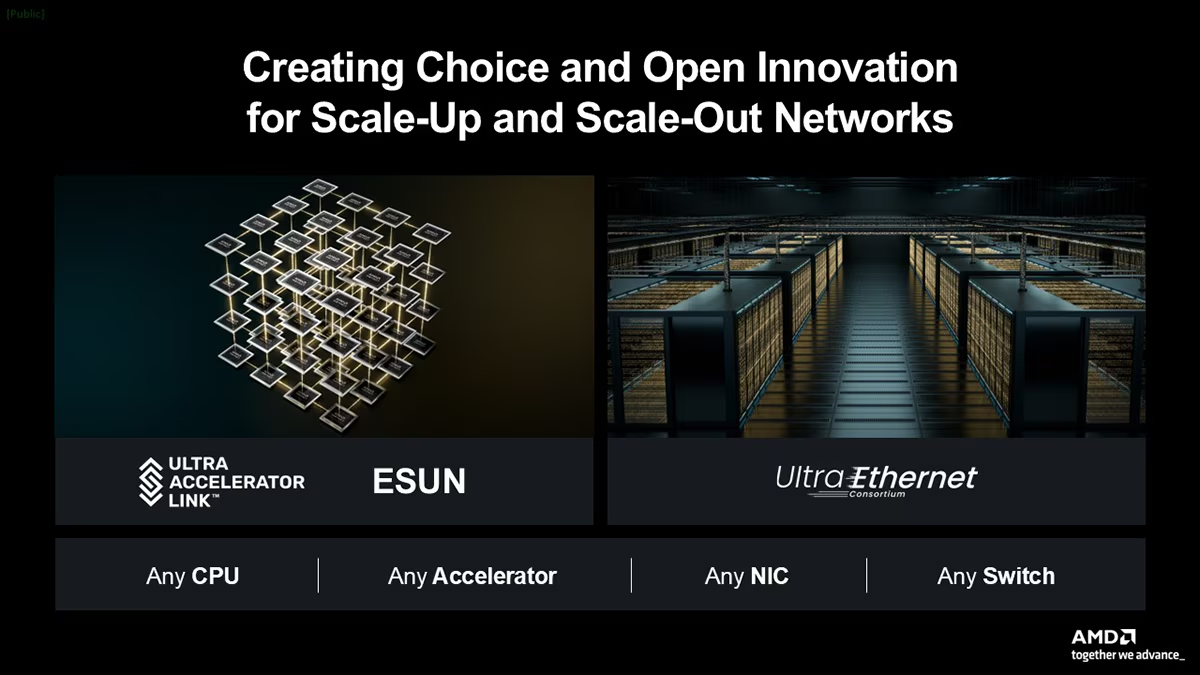

AMD impulsa consorcios como UALink, UltraEthernet y la iniciativa OCP ESUN para combinar protocolos de baja latencia con compatibilidad sobre Ethernet y permitir crecimiento de pods a medida que el tamaño del clúster aumenta.

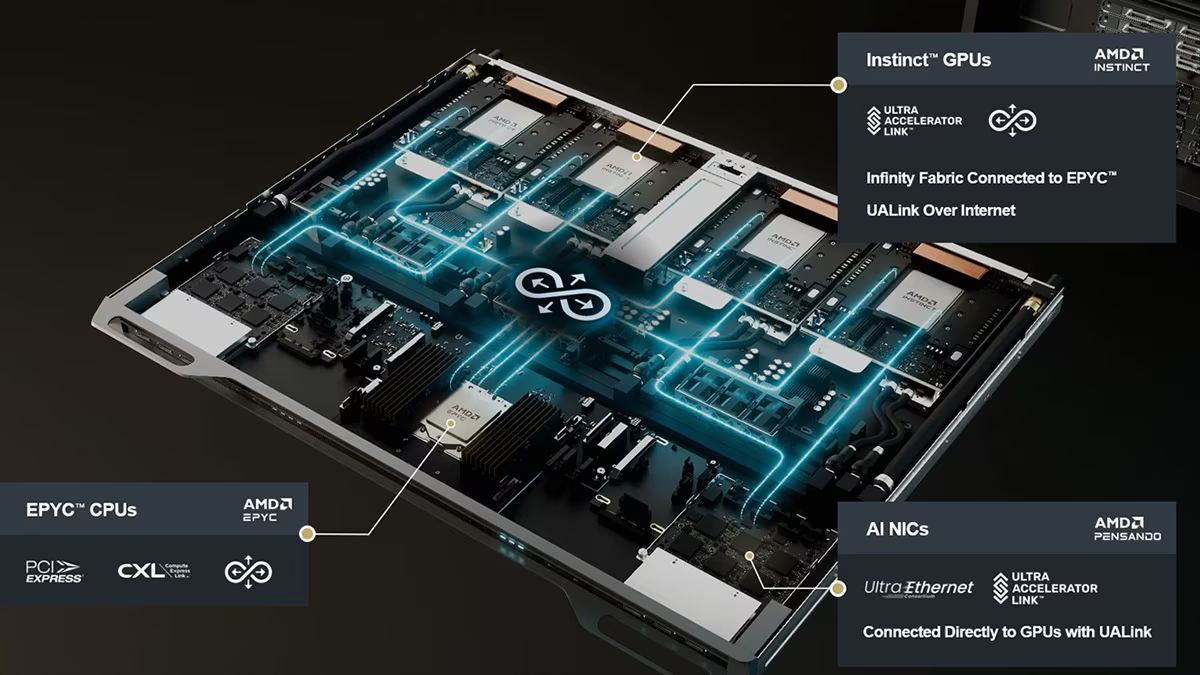

La hoja de ruta se concreta en Helios:

- Proyecto: Helios

- Tipo: Blueprint de racks abiertos (open rack blueprint)

- Estandarización: Basado en Open Rack Wide

- Componentes principales:

- CPU AMD EPYC

- GPU AMD Instinct

- NICs de alto rendimiento

- Software ROCm para cómputo acelerado

- Conectividad interna: Enlace directo entre GPU y NIC mediante UALink

- Escalamiento entre racks: Implementado a través de UALink-over-Ethernet

- Alineamiento industrial: Compatible con los lineamientos de interoperabilidad promovidos por ESUN y UltraEthernet Consortium

A continuación se presenta la data técnica clave del anuncio, con énfasis en conectividad, disponibilidad y seguridad. Se incluyen los elementos de diseño de rack, compatibilidad de redes y capacidades de protección de datos y modelos para despliegues soberanos y entornos compartidos.

- Helios: solución de rack de IA optimizada bajo estándar Open Rack Wide

- Disponibilidad objetivo: 2026

- Componentes: EPYC, Instinct, Pensando, ROCm

- Interconexión scale-up: UALink con eficiencia de protocolo y latencia ultra baja

- Escalamiento entre racks: UALink-over-Ethernet habilitado por ESUN

- Compatibilidad de red: alineada con el UltraEthernet Consortium

- Roadmap Instinct: soporte para UALink-over-Ethernet y fabrics nativos con switches UALink

- Objetivo de diseño: operar como máquina cohesiva a nivel de rack y clúster

- Confidential Computing: cifrado de memoria de extremo a extremo y aislamiento seguro de VMs en EPYC e Instinct

- Casos de uso: infraestructura de IA soberana y cargas sensibles en dominios público y privado

La seguridad se integra a la innovación con Confidential Computing que protege datos y modelos incluso durante el procesamiento activo y que extiende aislamiento y cifrado a través de CPU y GPU para mantener confianza operativa. El enfoque busca habilitar despliegues de IA que cumplan requisitos regulatorios sin sacrificar rendimiento.

El mensaje final es que los ecosistemas abiertos aceleran adopción y reducen fricción técnica, por lo que la colaboración en hardware, redes y software es condición para satisfacer la demanda de cómputo, memoria y networking en IA. AMD refuerza su compromiso con platafor