En un entorno corporativo donde la optimización de costos y la velocidad de procesamiento son críticos, la infraestructura de inteligencia artificial ha dejado de ser un commodity para convertirse en una ventaja competitiva central. La capacidad de ejecutar modelos de lenguaje masivos con eficiencia económica define hoy la viabilidad de las estrategias de transformación digital en las grandes organizaciones.

Un salto cuántico en la economía de los tokens

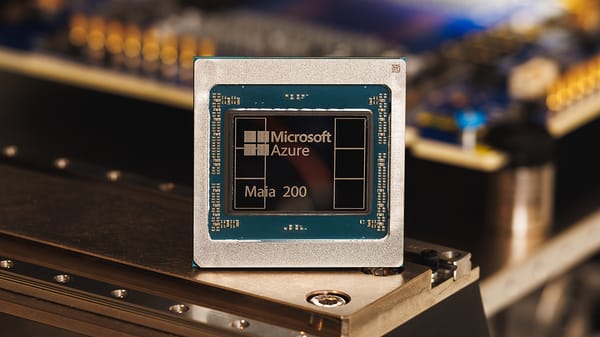

Microsoft ha dado un paso decisivo en esta carrera con la presentación de Maia 200, un acelerador de inferencia de próxima generación diseñado específicamente para maximizar el rendimiento por vatio y por dólar en la nube. Fabricado bajo un proceso de 3 nanómetros de TSMC, este silicio no solo busca potencia bruta, sino que ataca directamente los cuellos de botella de memoria que limitan a los modelos actuales.

La arquitectura del chip integra núcleos tensoriales nativos para formatos de baja precisión (FP8 y FP4) y un subsistema de memoria rediseñado con 216 GB de HBM3e. Esta configuración permite un ancho de banda de 7 TB/s, garantizando que los motores de movimiento de datos mantengan una alta tasa de utilización en cargas de trabajo intensivas.

El impacto en la operación es tangible: Maia 200 ofrece tres veces el rendimiento en FP4 comparado con la tercera generación de aceleradores de Amazon y supera en métricas FP8 a los TPU de séptima generación de Google. Para las empresas que dependen de Azure, esto se traduce en una mejora del 30% en rendimiento por dólar frente a la infraestructura actual.

Scott Guthrie, vicepresidente ejecutivo de Cloud + IA en Microsoft, destaca cómo este desarrollo cambia la ecuación económica para el despliegue de modelos masivos.

"Hoy, nos enorgullece presentar Maia 200, un acelerador de inferencia revolucionario diseñado para mejorar de manera importante la economía de la generación de tokens con IA".

Infraestructura escalable para la era de la IA generativa

La implementación de Maia 200 va más allá del hardware; representa una evolución en la arquitectura de centros de datos de Microsoft. El sistema introduce un diseño de red optimizado sobre Ethernet estándar, eliminando la dependencia de tejidos propietarios y facilitando una escalabilidad fluida entre clústeres.

Este ecosistema soportará cargas de trabajo críticas, desde los modelos GPT-5.2 de OpenAI hasta las operaciones de Microsoft 365 Copilot. Además, el despliegue incluye un enfoque de desarrollo nativo que integra software y hardware, permitiendo a los desarrolladores optimizar sus modelos mediante un SDK robusto compatible con PyTorch y Triton.

Con su puesta en marcha inicial en la región central de Estados Unidos, Microsoft asegura que este programa es solo el comienzo de una estrategia multigeneracional destinada a redefinir los límites de la infraestructura para inteligencia artificial a gran escala.