La integridad de los datos corporativos enfrenta un nuevo vector de amenaza con la sofisticación de las inyecciones de prompts, obligando a las organizaciones a replantear sus perímetros de seguridad en la inteligencia artificial.

En respuesta a esta necesidad crítica de protección de activos digitales, OpenAI ha desplegado una arquitectura de seguridad defensiva diseñada específicamente para mitigar riesgos en entornos de alta confidencialidad.

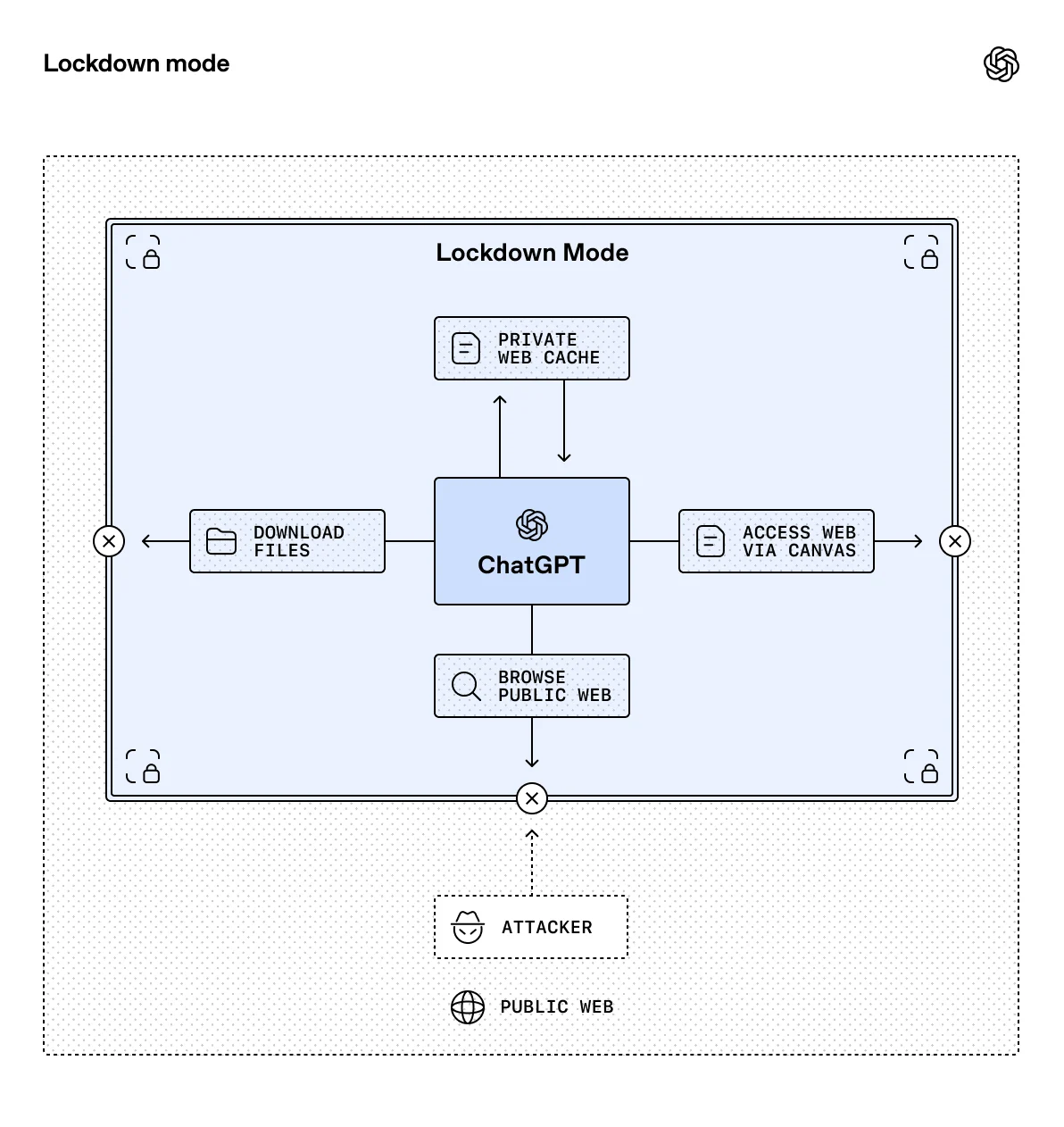

Lockdown Mode: Defensa determinista en profundidad

La implementación del 'Lockdown Mode' representa un cambio de paradigma desde la flexibilidad operativa hacia una postura de seguridad estricta para perfiles ejecutivos y equipos de ciberseguridad. Esta funcionalidad avanzada no es una configuración estándar, sino un protocolo diseñado para neutralizar la exfiltración de datos al restringir severamente las interacciones de ChatGPT con sistemas externos.

Bajo este protocolo, la navegación web se limita técnicamente a contenido en caché, eliminando las solicitudes de red en tiempo real que podrían ser explotadas por actores maliciosos. El sistema opera bajo un principio de desconfianza, desactivando preventivamente cualquier funcionalidad que no pueda ofrecer garantías matemáticas de seguridad en el manejo de la información.

Visibilidad de riesgos y control administrativo

La gestión del riesgo tecnológico requiere una taxonomía clara que permita a los tomadores de decisiones identificar vulnerabilidades potenciales antes de que se conviertan en incidentes.

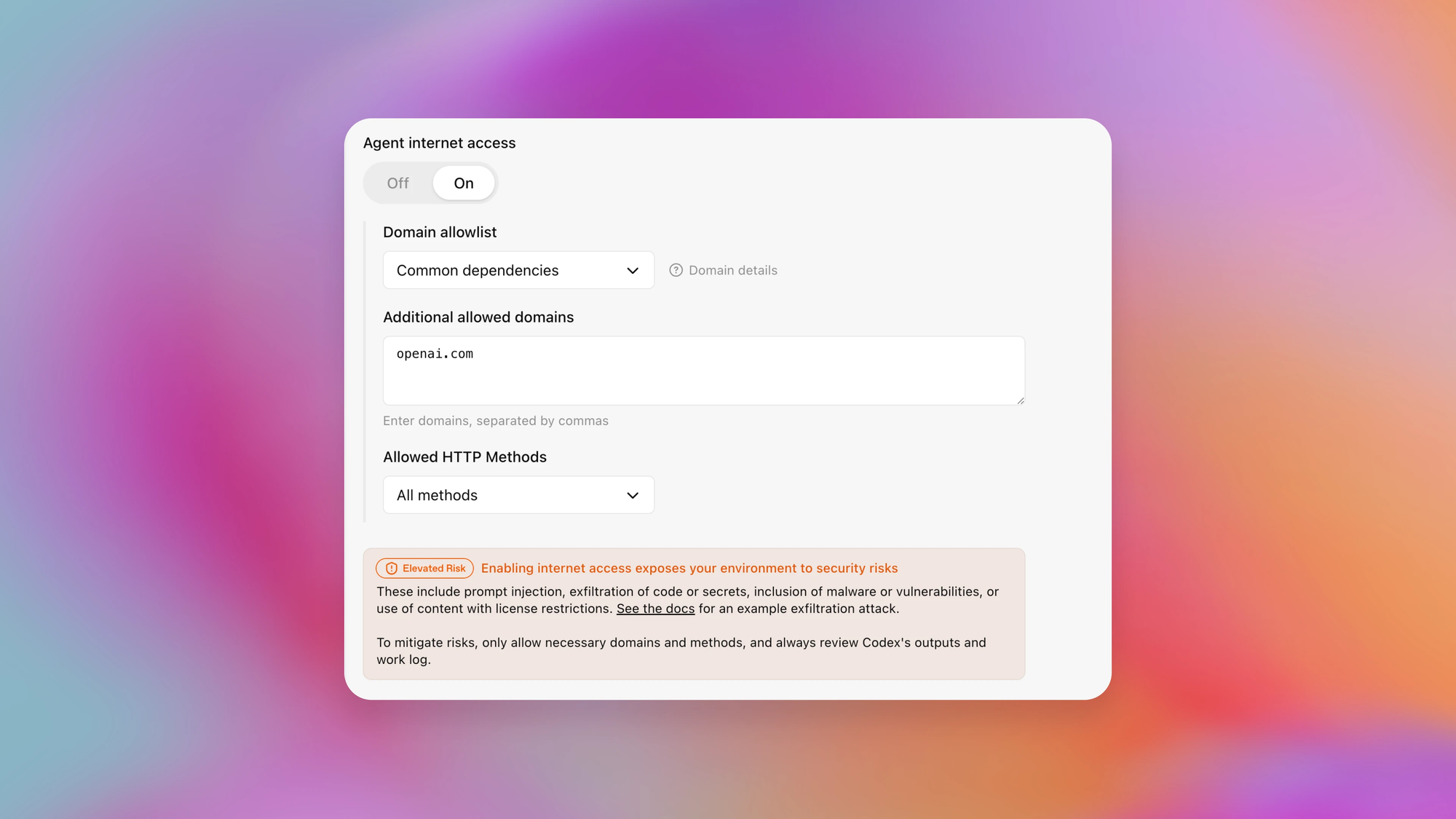

OpenAI ha estandarizado las etiquetas de "Riesgo Elevado" en sus plataformas empresariales, incluyendo ChatGPT Enterprise y Codex, para señalizar inequívocamente las capacidades que requieren conectividad abierta.

Estas herramientas de gobernanza se integran directamente en los controles administrativos existentes, permitiendo a los líderes de TI definir con precisión qué aplicaciones permanecen accesibles. La estrategia busca equilibrar la innovación operativa con el cumplimiento normativo, asegurando que la adopción de la IA generativa no comprometa la postura de seguridad de la corporación.