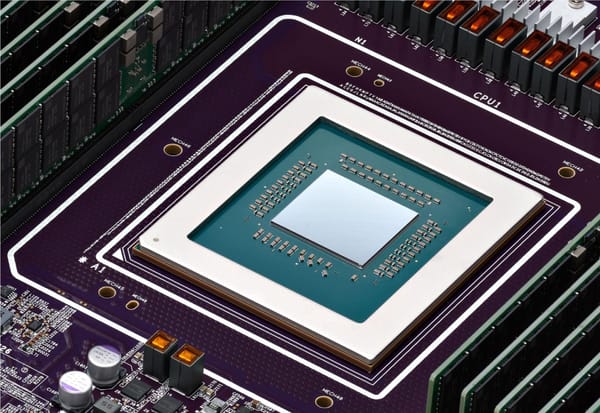

Google Cloud presentó dos nuevas soluciones de infraestructura diseñadas para responder a la creciente demanda de cómputo en inteligencia artificial: las TPU Ironwood, séptima generación de sus aceleradores personalizados, y las instancias Axion, basadas en arquitectura Arm. Ambas tecnologías buscan mejorar el rendimiento, la eficiencia energética y la rentabilidad en entornos de entrenamiento e inferencia de modelos de gran escala.

El anuncio se enmarca en un contexto donde la inteligencia artificial entra en una fase de madurez operativa. Las organizaciones ya no solo entrenan modelos, sino que deben desplegarlos a escala, con alta disponibilidad y control de costos. Esta etapa, conocida como la era de la inferencia, exige infraestructuras más flexibles, coordinadas y sostenibles.

Un salto en rendimiento: Ironwood y el sistema AI Hypercomputer

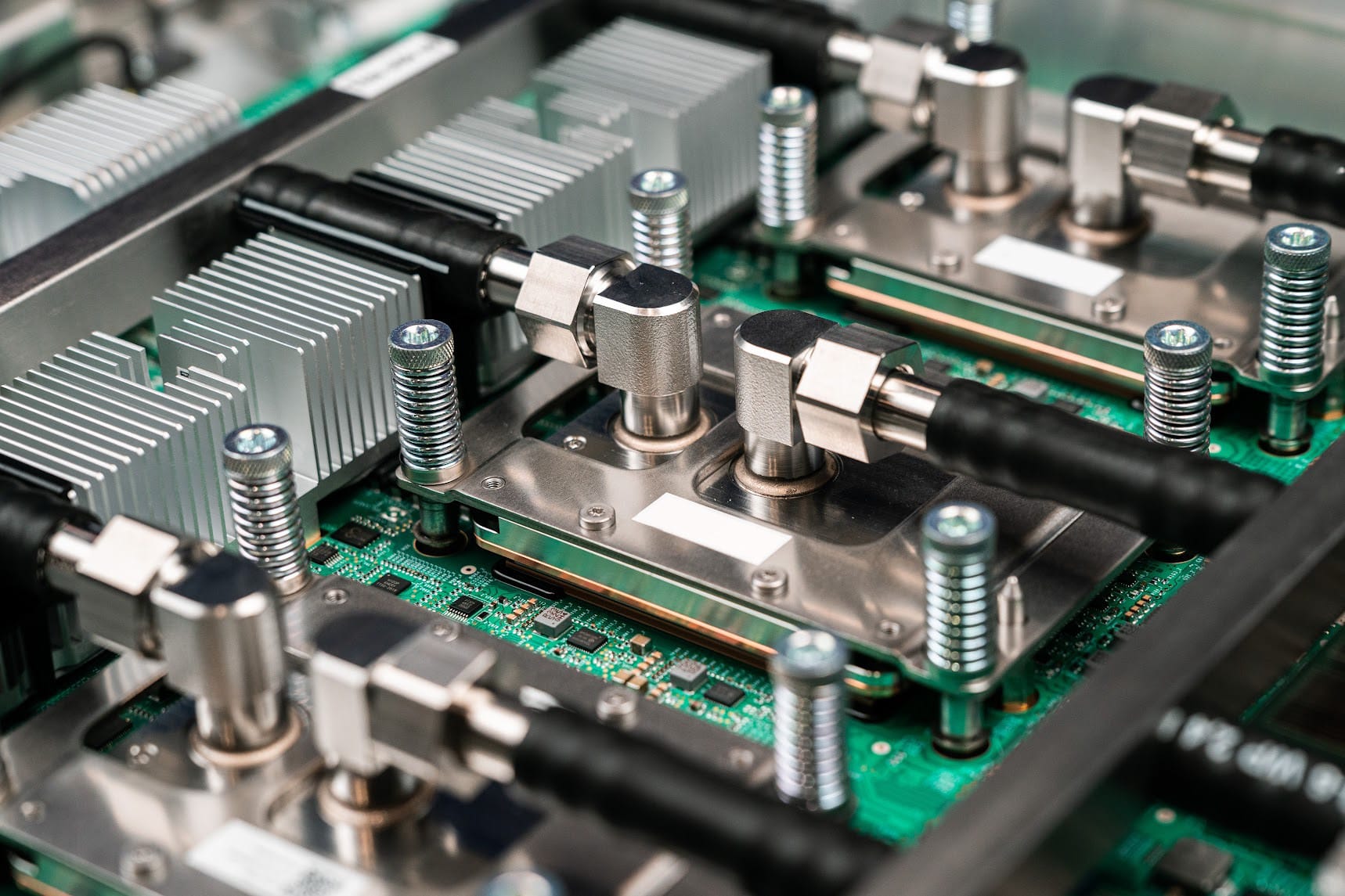

Las TPU Ironwood fueron desarrolladas para soportar cargas de trabajo complejas, desde entrenamiento de modelos fundacionales hasta inferencia de baja latencia. Google reporta que esta generación ofrece hasta diez veces más rendimiento pico que la TPU v5p y cuatro veces más rendimiento por chip en comparación con la versión anterior (TPU v6e).

Cada conjunto de Ironwood puede reunir múltiples chips interconectados para operar como una sola unidad de cómputo. Sus principales características son:

- 9.216 chips interconectados en un mismo dominio.

- Red Inter-Chip Interconnect (ICI) con ancho de banda de 9,6 terabits por segundo.

- 1,77 petabytes de memoria HBM compartida de alta velocidad.

- Arquitectura optimizada para procesar modelos multimodales a gran escala sin cuellos de botella de datos.

Además, el sistema utiliza Optical Circuit Switching (OCS), una red óptica dinámica que redirige procesos de manera automática ante fallos o congestión, garantizando continuidad operativa sin intervención manual.

Ecosistema de software y optimización

Ironwood se integra con nuevas herramientas que permiten un uso más eficiente de los recursos de cómputo. Entre ellas, Google Kubernetes Engine (GKE) incorpora capacidades de administración avanzada y programación inteligente de clústeres.

También se actualizó MaxText, el marco de código abierto optimizado para modelos de lenguaje (LLM), que ahora incluye soporte para ajuste fino supervisado y aprendizaje por refuerzo. Otras soluciones, como vLLM y GKE Inference Gateway, facilitan la ejecución híbrida entre GPUs y TPUs, reduciendo la latencia de respuesta hasta en 96 % y los costos operativos hasta en 30 %.

Casos de uso: Ironwood en empresas de vanguardia

El nuevo hardware ya está siendo adoptado por actores relevantes en investigación y desarrollo de IA generativa.

James Bradbury, Head of Compute en Anthropic, señaló que la compañía ve en Ironwood una oportunidad para escalar su modelo Claude manteniendo la confiabilidad operativa.

"Nuestros clientes, desde grandes corporaciones hasta startups, dependen de Claude para tareas críticas. A medida que la demanda crece, aumentamos nuestros recursos de cómputo y las mejoras de Ironwood en inferencia y escalabilidad de entrenamiento nos ayudarán a crecer con eficiencia y mantener la confiabilidad que esperan nuestros usuarios".

Yoav HaCohen, PhD, Director de Investigación en IA Generativa de Lightricks, destacó que la infraestructura de Google Cloud ha sido clave para entrenar y escalar su modelo multimodal LTX-2, centrado en creatividad asistida por IA.

"Nuestra misión en Lightricks es definir el límite de la creatividad abierta, y eso exige una infraestructura de IA que elimine fricción y reduzca costos. Las pruebas iniciales con Ironwood nos entusiasman: creemos que permitirá generar imágenes y videos más precisos, con mayor detalle y fidelidad para nuestros millones de usuarios".

Philip Monk, Infrastructure Lead en Essential AI, enfatizó que la facilidad de implementación y la capacidad de escalar con bajo costo son determinantes para acelerar la innovación en modelos abiertos.

"En Essential AI, nuestra misión es desarrollar modelos potentes y abiertos. Necesitamos escala y eficiencia, y las TPUs Ironwood nos ofrecen exactamente eso. La plataforma es sencilla de adoptar, lo que nos permite concentrarnos en acelerar los avances en inteligencia artificial".

Axion: eficiencia y flexibilidad en cómputo general

Junto con Ironwood, Google amplió su línea de procesadores Axion, desarrollados sobre arquitectura Arm Neoverse. Estas instancias están diseñadas para cargas de trabajo generales, como microservicios, bases de datos, procesamiento de datos y desarrollo de software.

Principales especificaciones del portafolio Axion:

- N4A (vista previa): hasta 64 vCPUs y 512 GB de memoria DDR5.

- C4A Metal (vista previa próxima): hasta 96 vCPUs y 768 GB de RAM.

- Compatibilidad con almacenamiento Hyperdisk y redes de hasta 100 Gbps.

- Soporte para cargas con requisitos de latencia o licencias específicas.

Estas capacidades permiten reducir el costo total de operación frente a instancias basadas en x86, manteniendo un equilibrio entre rendimiento, consumo energético y flexibilidad.

Joe Peled, Senior Director of Hosting & Delivery Ops en Vimeo, explicó que las pruebas iniciales con las instancias Axion N4A confirmaron mejoras sustanciales en eficiencia sin requerir cambios en la arquitectura operativa existente.

"Hemos observado una mejora del 30 % en el rendimiento de nuestro flujo principal de transcodificación con las instancias Axion N4A, sin modificar nuestra arquitectura operativa. Esto abre una vía clara para escalar nuestros servicios con mayor rentabilidad".

Sergei Koren, Chief Infrastructure Architect en ZoomInfo, señaló que la eficiencia lograda con las nuevas instancias permite una entrega más rápida de información a sus clientes y una mayor optimización de recursos.

"En nuestra revisión de las nuevas instancias N4A, medimos una mejora del 60 % en la relación precio-rendimiento frente a las instancias x86 equivalentes. Esto nos permite escalar más rápido y ofrecer más valor a nuestros clientes".

Or Ben Dahan, Cloud & Software Architect en Rise, subrayó el impacto directo que la adopción de la línea Axion tuvo en la eficiencia operativa y los márgenes del negocio.

"Migrar al portafolio Axion de Google Cloud nos dio una ventaja competitiva clave. Reducimos el consumo de cómputo en un 20 % y estabilizamos la latencia con las instancias C4A. Varias de nuestras aplicaciones ya consumen 15 % menos CPU que antes, lo que mejora los márgenes operativos".

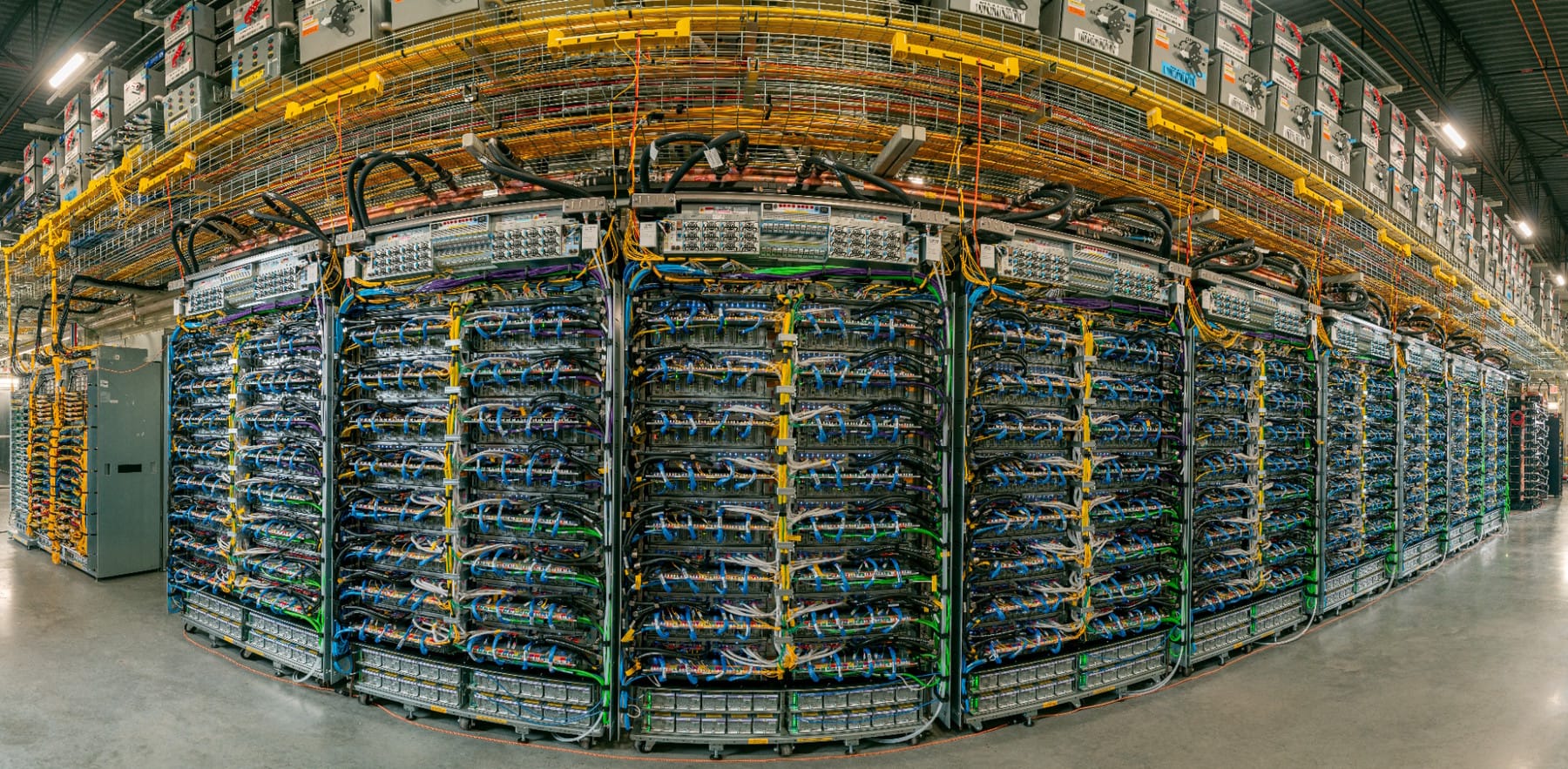

Infraestructura para la próxima década

Ironwood y Axion consolidan el enfoque de Google Cloud hacia el co-diseño de hardware, red y software como estrategia para mejorar la eficiencia del cómputo a escala. Estas soluciones buscan ofrecer un marco sostenible y flexible para organizaciones que dependen de la inteligencia artificial, desde laboratorios de investigación hasta compañías globales que operan servicios digitales críticos.

En conjunto, ambos desarrollos representan la apuesta de Google por una infraestructura capaz de sostener el crecimiento de la IA en la próxima década: más rápida, más eficiente y con un menor costo por unidad de cómputo.